Simar Bajaj en The New York Times:

Aunque los chatbots de inteligencia artificial prometen respuestas detalladas y personalizadas, también ofrecen validación a la carta: la posibilidad de sentirse visto, comprendido y aceptado al instante. Tus amigos y familiares pueden sentirse frustrados o molestos contigo, pero los chatbots tienden a ser extra agradables y tranquilizadores.

Esta validación no es necesariamente mala. Tal vez estés ansioso por un proyecto de trabajo, pero el chatbot dice que tu idea es muy buena y elogia tu creatividad. Tal vez tengas una fuerte discusión con un compañero, pero ChatGPT te dice lo meditada y justificada que es tu perspectiva.

Sin embargo, esa aprobación constante puede ser peligrosa, y dar lugar a errores de juicio y a una certeza equivocada. Un estudio reciente ha demostrado que, si introduces información errónea en los chatbots de IA, pueden repetir y detallar información falsa. El Times también ha informado que el ChatGPT puede llevar a los usuarios a espirales delirantes y puede disuadir a las personas con tendencias suicidas de buscar ayuda.

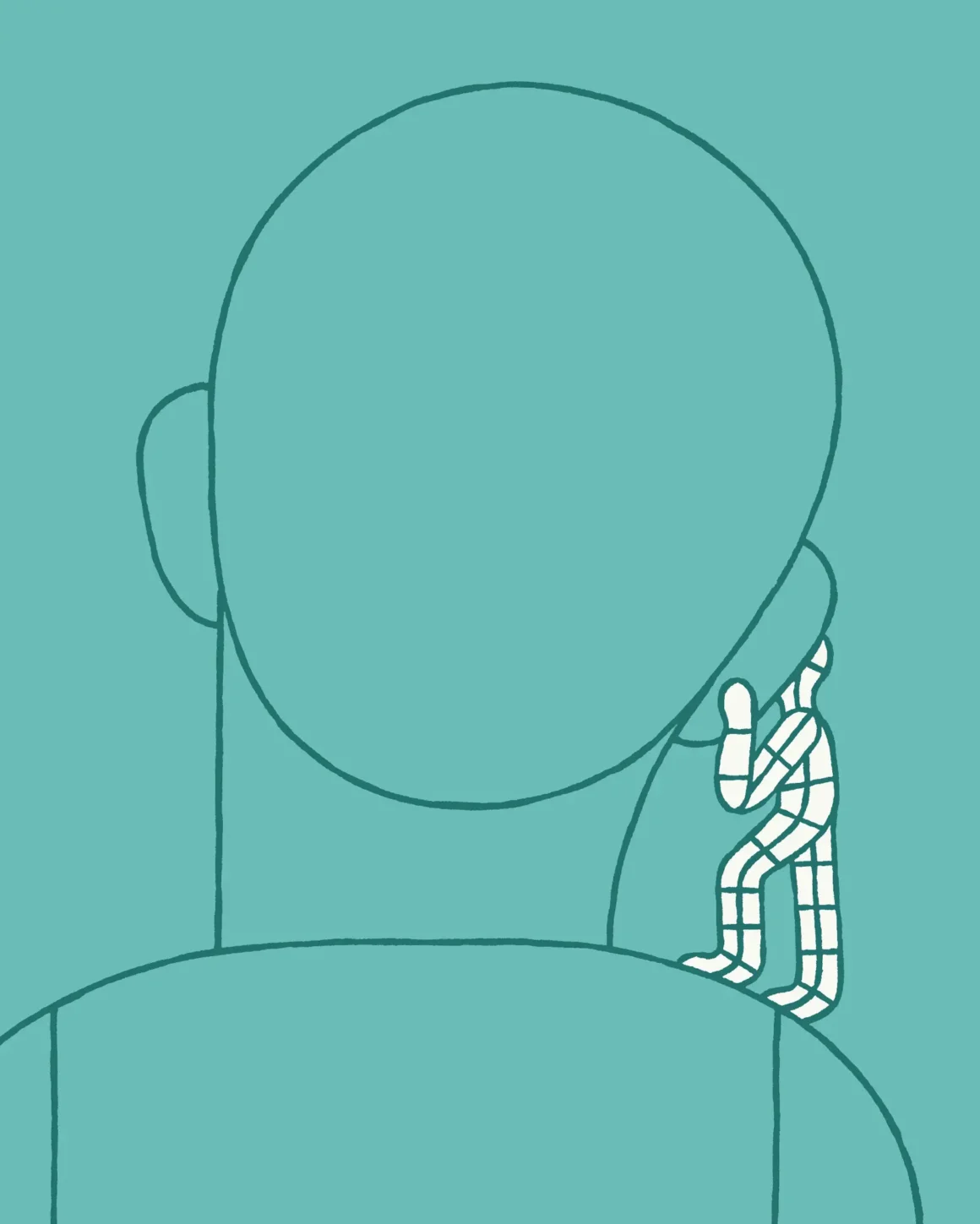

Un chatbot de IA es como un “espejo distorsionado”, comentó Matthew Nour, psiquiatra e investigador de IA de la Universidad de Oxford. Crees que se trata de una perspectiva neutral, añadió, pero el modelo está reflejando tus propios pensamientos, con una capa de adulación.

Es un excelente artículo con recomendaciones claras para no quedar atrapado en la necesidad de validación constante de la IA. Al final, vale la pena recordarlo: las relaciones humanas reales implican fricciones y límites; ninguna relación puede sostenerse ni crecer si todo es aprobación, y la IA es justo eso aprobación sin control.

Lee el artículo completo en The New York Times.